Jupyter AI

Im bwJupyter - Jupyter AI Profil steht Jupyter AI, ein integrierter KI-Assistent, zur Verfügung, der als Unterstützung bei der Entwicklung genutzt werden kann. Das Profil basiert auf dem offiziellen Jupyter-Profil Datascience. Daher sind dort bereits gängige Pakete für Python, Julia und R vorinstalliert.

Dokumentation für Studierende

In den folgenden Abschnitten zeigen wir Ihnen wie Sie den KI-Assistenten konfigurieren und verwenden können.

Profil starten

Entweder stellt Ihnen Ihre Dozentin bzw. Ihr Dozent einen Link zu einem bereits vorbereiteten Profil zur Verfügung. In diesem Fall können Sie direkt mit der Konfiguration Ihres KI-Assistenten beginnen (siehe nachfolgenden Abschnitt).

Falls Sie keinen solchen Link erhalten haben, können Sie auf der Startseite unter bwJupyter-Profile das Profil bwJupyter – Jupyter AI auswählen und starten. Auch hier ist anschließend die Konfiguration des KI-Assistenten erforderlich, bevor Sie ihn nutzen können.

KI-Assistent konfigurieren

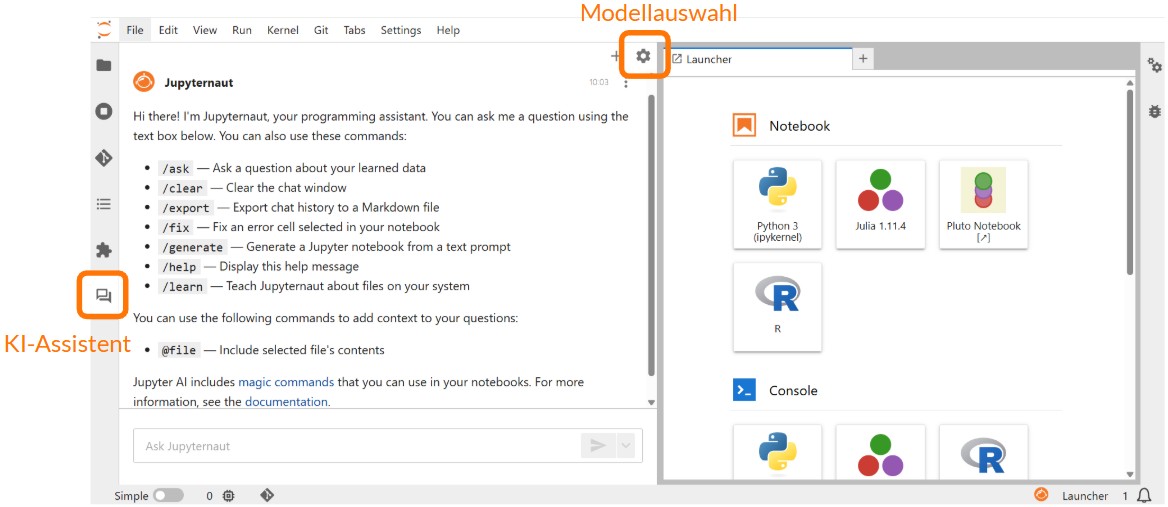

Nachdem das Profil gestartet wurde, erscheint in der linken Seitenleiste ein neues Nachrichten-Icon. Dort kann der Chatbot verwendet und das zugrundeliegende Large Language Model (LLM) konfiguriert werden.

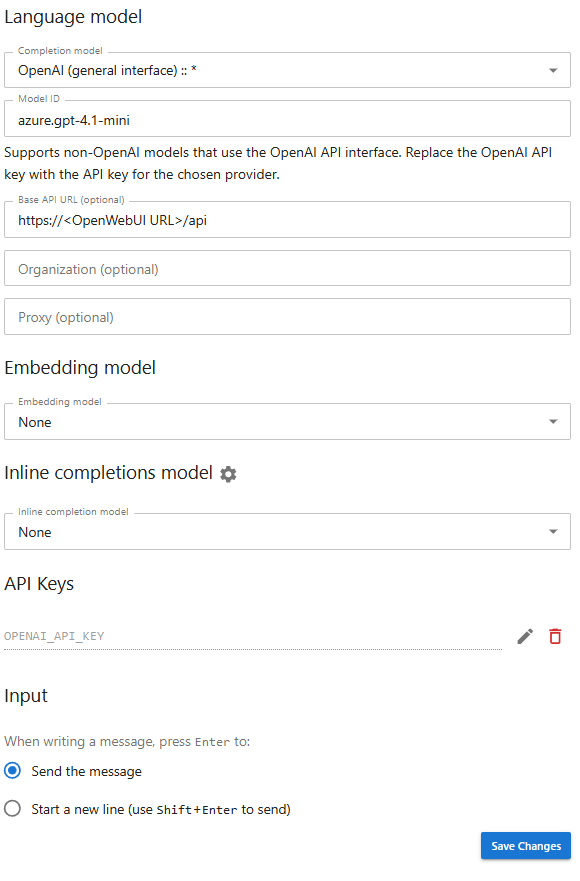

Bei der ersten Nutzung des KI-Assistenten müssen Sie die LLMs angeben, die Ihre Anfragen bearbeiten werden. Für die Nutzung des KI-Assistenten müssen LLMs für „Language model“ und „Embedding model“ zwingend festgelegt sein. Eine Festlegung für „Inline completions model“ muss nur getroffen werden, falls die KI-gestützte Code-Vervollständigung genutzt werden soll. Die Konfiguration wird Profil-übergreifend gespeichert, sodass die Modelle im Idealfall nur einmal konfiguriert werden müssen.

Bei der Modellauswahl erhalten Sie eine Liste zahlreicher Anbieter. Die Modelle können Sie nicht einfach auswählen und nutzen. Fast alle Anbieter fragen nach einem API-Key, damit die Nutzung der Modelle entsprechend zugeordnet und abgerechnet werden kann. Da es aktuell keinen Landesdienst gibt, der LLMs zur Verfügung stellt, müssen alle Hochschulen und Nutzenden sich um einen entsprechenden Zugang kümmern.

Falls Sie den KI-Assistenten nur mit wenigen Anfragen testen möchten, können Sie eines der Modelle "bwJupyter (KI-Toolbox @ KIT, demo only) :: [Modell]" auswählen. Die Modelle werden vom KIT im Rahmen der KI-Toolbox kostenlos als Demoversion zur Verfügung gestellt. Für diese LLMs ist kein eigener API-Key notwendig. Bitte beachten Sie hierbei, dass die Nutzung der KI-Toolbox-Modelle limitiert ist. Falls Sie auf den Fehler "429 Rate limit reached" stoßen, wurde das Kontingent bereits genutzt. Sie können es nach einer Stunde erneut probieren. Nutzenden innerhalb des KIT steht die Vollversion ohne Limitierung zur Verfügung.

Im Folgenden zeigen wir Ihnen wie Sie Modelle verschiedener anderer Anbieter einbinden können. Zu diesen Anbietern zählen zum Beispiel folgende:

- Die GWDG stellt auf Anfrage den Zugriff auf LLMs im Rahmen ihrer AI Services zur Verfügung. Über die Anfrage erhalten Sie die Modell-ID und einen API-Key, die Sie benötigen, um das Modell in bwJupyter nutzen zu können. Eine Liste aller verfügbaren LLMs und deren Fähigkeiten sowie mehr Information zur Anfragestellung finden Sie in der GWDG-Dokumentation.

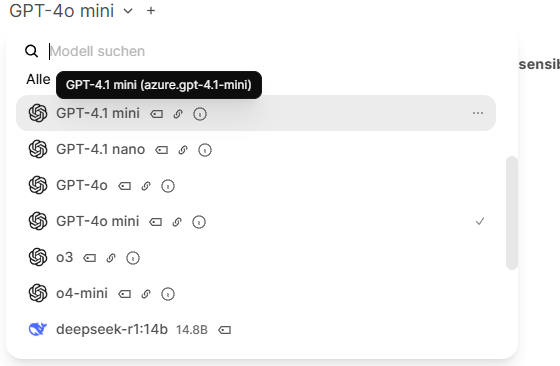

- Manche Hochschulen betreiben OpenWebUI. OpenWebUI stellt eine Web-Oberfläche ähnlich zu ChatGPT bereit. Administratoren können mehrere LLMs hinterlegen, die man anschließend über den Chat ansprechen kann. Damit man die Modelle über die OpenWebUI auch in bwJupyter nutzen kann, benötigt man einen API-Key und die Modell-ID. Den API-Key kann man über "Einstellungen >> Konto >> API-Schlüssel" erzeugen. Die Modell-ID wird bei der Modellauswahl angezeigt, nachdem man den Curser über ein Modell zieht.

Die Modell-ID wird in Klammern nach dem Modell angezeigt.

In bwJupyter lassen sich API-Key und Modell-ID für ein Modell (hier zum Beispiel "OpenAI (general interface) :: *") wie folgt eintragen:

Wenn Sie Zugang zu LLMs haben, aber nicht wissen wie Sie die Modelle bei bwJupyter einbinden können, schreiben Sie uns eine kurze Mail an support∂bwjupyter.de.

KI-Assistent verwenden

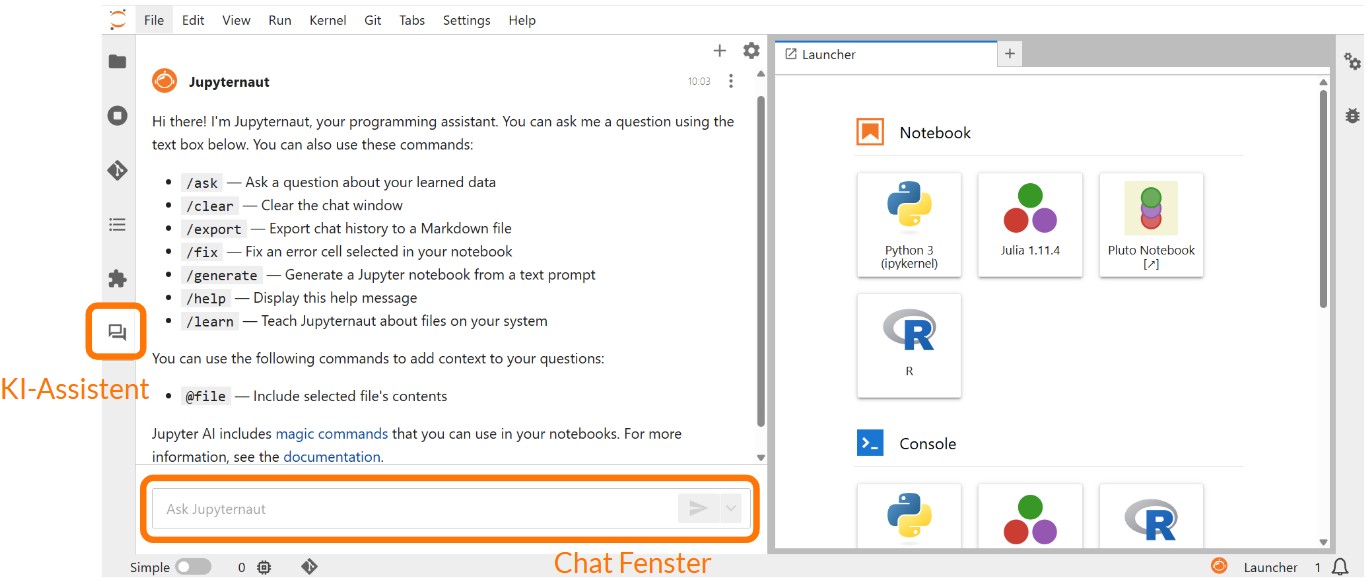

Der KI-Assistent bietet auf drei verschiedenen Arten Unterstützung: eine Chat- Benutzeroberfläche, AI Magic Commands und eine KI-gestützte Inline Completion.

Chat-Benutzeroberfläche

Über die Chat-Benutzeroberfläche können natürlichsprachliche Anfragen im Chat an die generative KI gestellt werden. Sie öffnet sich nach Anwählen des Sprechblasensymbols am linken Bildschirmrand. Im Chat-Fenster wird die Anfrage an den KI-Assistenten eingegeben.

Die natürlichsprachlichen Anfragen können mit folgenden Befehlen spezifiziert werden:

- /ask (Eine Frage zu gelernten Daten stellen)

- /clear (Chatfenster leeren)

- /export (Chathistorie exportieren)

- /fix (Fehler in einer ausgewählten Zelle des Notebooks beheben)

- /generate (Ein Jupyter Notebook generieren)

- /help (Hilfe anzeigen)

- /learn (Lokale Daten einlesen – hier muss der Dateipfad angegeben werden)

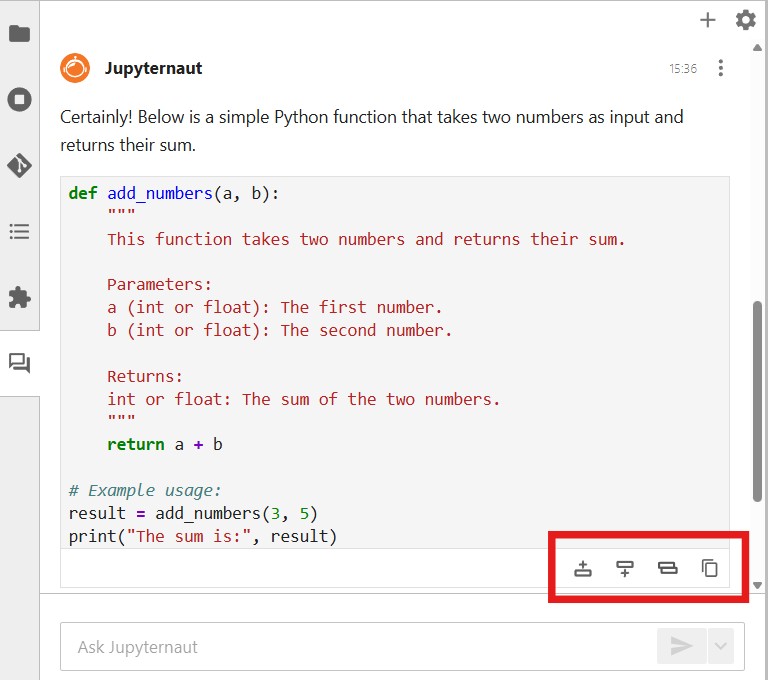

Code, den der KI-Assistent ausgibt, kann über die Symbole unten rechts an der ausgegebenen Codezelle direkt in ein geöffnetes Jupyter-Notebook eingefügt werden. Durch Anklicken des jeweiligen Symbols lässt sich die Codezelle wahlweise oberhalb, unterhalb oder als Ersatz der aktuell ausgewählten Notebook-Zelle einfügen oder alternativ in die Zwischenablage kopieren.

Sie können außerdem direkt Anfragen zum Code einer ausgewählten Zelle stellen. Öffnen Sie dazu mit einem Rechtsklick auf die entsprechende Zelle das Kontextmenü und wählen Sie „Generative AI“ aus. Dort stehen Ihnen verschiedene Optionen zur Verfügung: Sie können sich den Code erklären lassen (Explain code), Fehler beheben lassen (Fix code), den Code optimieren (Optimize code) oder ihn umstrukturieren lassen (Refactor code). Der geänderte Code erscheint anschließend in der Chat-Oberfläche.

AI Magic Commands

Der KI-Assistent kann auch direkt im Jupyter Notebook über sogenannte AI Magic Commands innerhalb des Python-Codes genutzt werden. Damit lassen sich im Code sowohl das gewünschte KI-Modell auswählen als auch Anfragen an dieses stellen. Die Antworten erscheinen nach dem Ausführen der jeweiligen Codezelle als deren Ausgabe.

Inline Completion

Als dritte Komponente des KI-Assistenten steht eine KI-gestützte Code-Vervollständigung zur Verfügung. Um diese zu aktivieren, wählen Sie zunächst über die Schaltfläche mit dem Jupyternaut-Symbol (![]() ) unten rechts im Bildschirm die Option „Enable completions by Jupyternaut“ aus. Anschließend legen Sie in den Einstellungen des KI-Assistenten ein „Inline Completions Model“ fest. Wie Sie dieses auswählen, erfahren Sie im Abschnitt „KI-Assistent konfigurieren“.

) unten rechts im Bildschirm die Option „Enable completions by Jupyternaut“ aus. Anschließend legen Sie in den Einstellungen des KI-Assistenten ein „Inline Completions Model“ fest. Wie Sie dieses auswählen, erfahren Sie im Abschnitt „KI-Assistent konfigurieren“.

Dokumentation für Dozierende

Im folgenden Abschnitt zeigen wir Ihnen, wie Sie den integrierten KI-Assistenten für ein Profil aktivieren können. Für die Konfiguration und Nutzung des KI-Assistenten verweisen wir auf die vorangegangene Einführung für Studierende.

Feature aktivieren

Um ein personalisiertes Profil mit integriertem KI-Assistent anzulegen, muss beim Anlegen des neuen Profils die JupyterLab Environment „bwJupyter – JupyterAI“ ausgewählt werden. Sie müssen in diesem Profil anschließend ein KI-Modell auswählen um den KI-Assistenten zu konfigurieren. Diese Auswahl wird für die Studierenden, die das Profil nutzen, allerdings nicht übernommen. Jeder/ Jede Studierende muss diese Auswahl vor erstmaliger Nutzung des KI-Assistenten selbst vornehmen.

Die Informationen zur Nutzung des KI-Assistenten finden Sie außerdem als Video in einer Aufzeichnung zur Fortbildung zum KI-Assistenten und den zugehörigen Fortbildungsfolien.